Vous êtes ici

Nouvelle donne pour les cartes

Avec Olivier Ertz1, de l’Institut d’ingénierie des médias, en Suisse, vous avez rejoint l'Open Geospatial Consortium autour de l'idée d'un nouveau standard international pour la cartographie. Pour bien comprendre l’enjeu de votre travail, pouvez-vous nous expliquer ce qu’est conceptuellement une carte et ce que l’on en attend ?

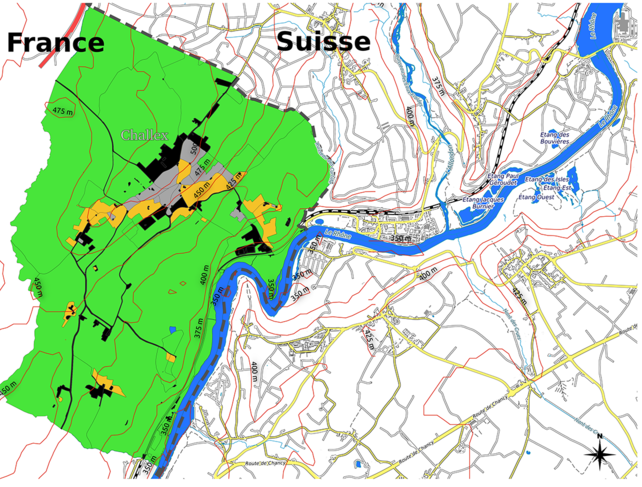

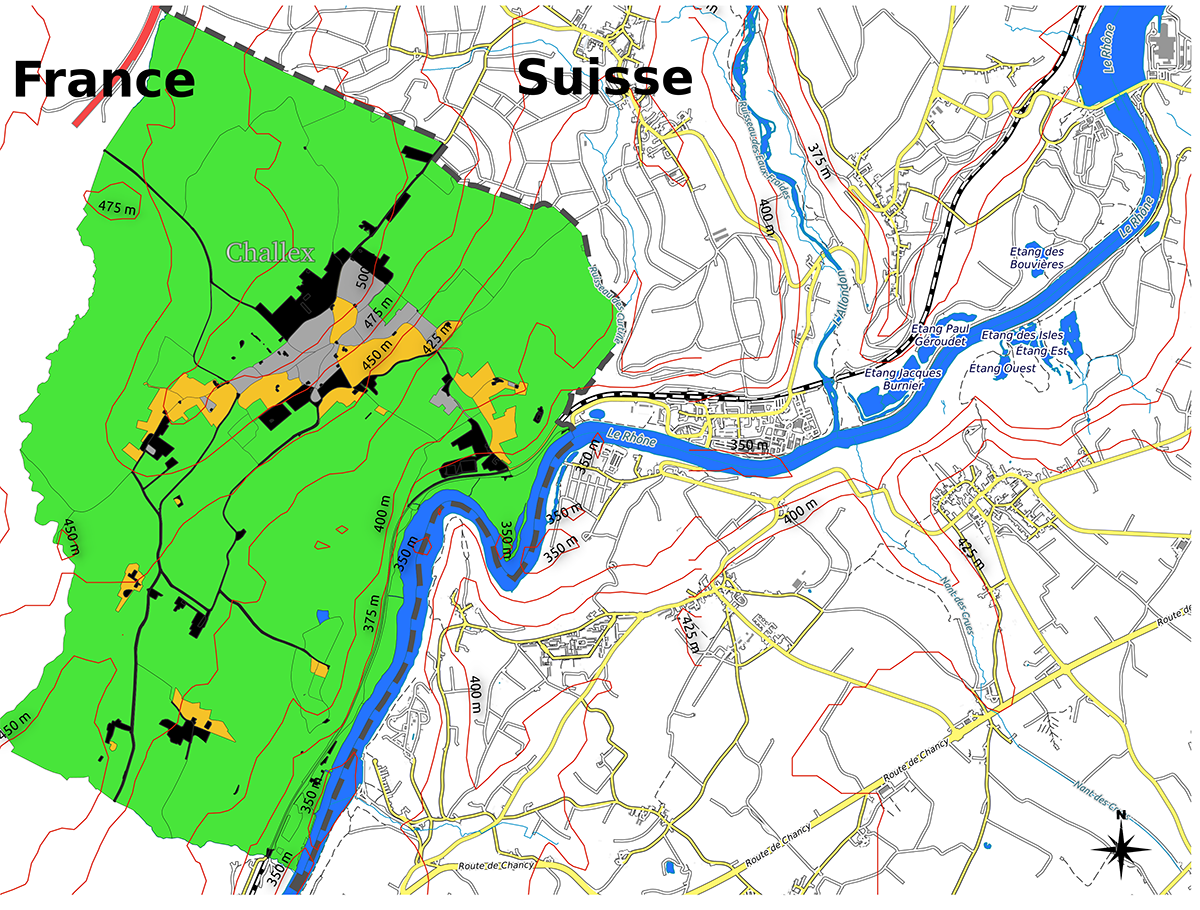

Erwan Bocher2 : Une carte est un objet qui transcrit des informations relatives à un territoire (topographie, population, température, niveau de la mer…) au terme d’un processus d’abstraction transformant des données provenant du réel en une série de symboles apposés sur un support représentant ce territoire. On attend de la carte qu’elle soit une représentation la plus fidèle possible des données à représenter, de telle sorte que si on sait la lire, on puisse embrasser en un regard l’organisation géographique d’un territoire. Mais dans une perspective d’aide à la décision, une carte est également un outil permettant de faire passer des messages. Par exemple, par un jeu de couleurs approprié, on peut représenter la concentration d’un polluant dans l’air de telle sorte que les zones où un certain seuil est dépassé apparaissent clairement.

Cette transformation de données en symboles pertinents est tout l’enjeu d’un standard cartographique, c’est bien ça ?

E. B. Exactement. Ce que nous appelons un langage commun standardisé d’éléments symboliques configurables, que l’on assemble pour créer une représentation cartographique. Appliqué à des données, le standard permet la définition d’une carte pour la visualisation de ces données dans l’espace.

Et vous avez donc proposé un nouveau standard générique pour la cartographie ?

E. B. En effet, avec Olivier Ertz, professeur en géoinformatique, nous avons mené une réflexion théorique afin de proposer une évolution en profondeur du standard actuel, pour le rendre graphiquement plus expressif, mais aussi évolutif et appropriable par l’ensemble des communautés intéressées aux enjeux de l’interopérabilité en cartographie. Nous avons en fait complètement repensé la façon de construire et de partager une carte.

Quel était précisément le problème avec le standard actuel ?

E. B. Un petit retour en arrière s’impose d'abord. Avant le boom d’Internet, au début des années 2000, chaque communauté (géologues, climatologues, épidémiologistes…) disposait uniquement de sa propre information géographique. Les données n’étaient pas mutualisées et il n’existait pas vraiment d'infrastructure ni de formats de mise en commun. Ainsi, chacun élaborait ses propres cartes de son côté. Mais grâce aux technologies de l’information et de la communication qui se généralisaient, les outils permettant de traiter et de restituer l’information géographique se sont radicalement transformés, ceux-ci permettant dès lors de partager très largement les données au sein d'infrastructures de données spatiales (IDS). On a alors assisté à une vaste entreprise de mutualisation des informations géographiques, largement encouragée par l’Open Geospatial Consortium (OGC).

Mutualiser et partager, cela offre évidemment un grand intérêt en termes de développement des connaissances. Pour les chercheurs, mais également dans la sphère institutionnelle, la possibilité de mutualiser de l’information est apparue comme une des conditions nécessaires à une meilleure gouvernance des territoires, de même qu’un gage d’efficacité et de transparence de l’action publique. À cet égard, on peut par exemple citer la Directive européenne Inspire, qui fixe un cadre pour que l’information géographique publique, en particulier environnementale, devienne accessible à tous. Concrètement, les grands acteurs de la géographie se sont réunis et nous avons assisté à la création des premiers serveurs géographiques pour le partage des géodonnées dont le géoportail de l’Institut de géographique national (IGN).

Et ce sont ces « géo-plateformes » qui reposent sur un standard ?

E. B. Absolument, et même sur de nombreux géostandards, dont ceux qui permettent de naviguer sur un territoire sous la forme de cartes interactives, et ce via des mécanismes eux aussi standardisés du Web. Plus précisément, le géostandard qui nous concerne s’appelle SymCore. Il pose le socle pour la définition de l’ensemble des règles à partir desquelles les données sont transformées en symboles.

Où était alors le problème ?

E. B. Je vais vous donner un exemple. En 2010, j’ai coordonné un projet de plateforme scientifique de mutualisation des données géographiques urbaines, en particulier les données environnementales : météo, bruit, pollution… Si nous avons pu utiliser des standards internationaux appropriés et en évolution régulière pour découvrir et partager de la donnée au travers de services géographiques, nous nous sommes aperçus que le standard pour partager des cartes était limité au regard de nos besoins, mais surtout qu’il n'évoluait plus.

Comment ça ?

E. B. Il existe de nombreux cas d'utilisation de ce que nous appelons « le partage des cartes ». Très simplifié, prenons celui d'un acteur d'une intercommunalité qui souhaite combiner sur une carte la représentation du réseau des eaux usées d'une commune X avec celle d'une commune Y. Si le serveur cartographique X symbolise cela avec un trait brun de fine épaisseur et le serveur cartographique Y avec un trait en violet et des symboles, alors l’assemblage des deux cartes offrira une composition visuelle non concordante et qui sera source de confusion avec d'autres éléments cartographiques. On comprend alors qu'il est utile de disposer d'un langage commun de description cartographique pour piloter de façon interopérable un ou plusieurs serveurs cartographiques d'une IDS selon une description personnalisée ou celle définie par une communauté d'utilisateurs pour un type de données (réseaux, météo, bruit).

La richesse du langage est alors importante, ce qui va avec sa capacité même à évoluer. En effet, la créativité cartographique des différentes communautés d’utilisateurs est forte. Or il faut bien l'avouer, les capacités de description du standard actuel sont basiques, amenant à des représentations très pauvres, notamment pour ce qui concerne la cartographie thématique. En termes d'évolution, pas mieux, on assiste à des initiatives unilatérales d'entreprises pour étendre ses capacités. L'intention est bonne, surtout pour satisfaire le client, mais elle met à mal les principes mêmes de l'interopérabilité et donc les possibilités de « partage des cartes » entre différents outils.

Quelle a été votre démarche ?

E. B. Selon nous, il était essentiel de commencer par mettre de côté toute considération technique pour nous concentrer exclusivement sur la théorie de l’utilisation des variables visuelles. Avec une question : « Comment construire le socle d'un standard évolutif tout en fournissant un langage capable d'inscrire les variables visuelles dans sa grammaire ? ». Pour ce faire, nous nous sommes appuyés sur les travaux en sémiologie graphique, ou science de la représentation graphique des données, du géographe Jacques Bertin. Avant lui, une bonne représentation devait essentiellement être précise et complète. Il a de son côté mis la priorité sur l’efficacité de la communication, en partant d’une analyse fine de tous les paramètres qui concourent à la transformation d’une information en dessin, depuis les capacités de l’œil humain jusqu’aux possibilités offertes par la graphie. À partir de quoi, il a proposé un ensemble de variables visuelles qui, combinées entre elles, permettent de construire des cartes. Pour nous, il s'agissait alors de reconceptualiser un standard existant (OGC Symbology Encoding) autour de ces concepts de sémiologie.

C’est très abstrait ?

E. B. Disons que l’idée est de partir des données auxquelles on applique un style cartographique qui contient l’ensemble des descripteurs permettant de les représenter : points, lignes, surfaces, couleurs, éléments textuels… En l’état, la nouveauté que nous proposons, baptisée Symbology Conceptual Core Model, acronyme SymCore, définit conceptuellement un ensemble de points d'extension de primitives cartographiques qui, utilisées par différentes communautés, ont pour objectif de fournir un langage commun pour construire des cartes. Utilisé en amont de la chaîne de production, il fournit un vocabulaire, des référents communs, offrant la possibilité de constituer des bibliothèques de descriptions cartographiques (on parle aussi de styles), l’enjeu étant de favoriser l’interopérabilité graphique entre logiciels et donc entre utilisateurs.

Comment ce travail académique a-t-il été reçu ?

E. B. À la suite de notre constat, nous nous sommes tournés vers l’OGC pour concrétiser les choses. Nous avons proposé de coordonner cette réflexion. La publication dans le journal PeerJ Computer Science3 expose la problématique et notre approche. Au départ, le consensus n'était vraiment pas là : il a fallu convaincre ! Dans un monde d’ingénieurs et de grands éditeurs, plus habitués à aborder un problème sous son angle technique, nous avons déployé un travail de pédagogie.

Comment avez-vous concrètement convaincu de la nécessité de revoir le standard géographique selon vos préconisations ?

E. B. Il a d'abord fallu recadrer les besoins sous-jacents. Par exemple, fin 2017, un vaste consortium impliquant les gouvernements des États-Unis et du Canada a décidé d’un projet de plateforme géographique faisant la synthèse de toutes les données sur l’Arctique. Or leurs experts, comme nous avec les données urbaines, ont réalisé qu’il était impossible de proposer des représentations complexes à partir du standard actuel. Ils se sont alors tournés vers l’OGC et ont eu vent de notre travail. Si bien qu’un rapport soutenu par le ministère des Ressources naturelles du Canada et l’US Army Geospatial Center, publié fin 2018, a confirmé la pertinence de notre approche !

Et votre travail a été accepté.

E. B. Après plusieurs années de travail sur fonds propres, le nouveau standard SymCore est finalement publié à l'automne 2020. Le consensus était là et fort. Il est le fruit de plusieurs mois de discussions avec les acteurs de la géomatique à l’OGC et de deux itérations d'appel à commentaires, durant lesquelles nous avons répondu point par point à toutes les questions et pris en compte les dernières propositions d'amélioration demandées par la communauté internationale..

On peut s’attendre à une révolution dans le monde de la cartographie ?

E. B. Plutôt à un nouveau départ, avec une vision de long terme. Ensuite, les différentes communautés intéressées par la cartographie devront s’en emparer et construire, à partir de ce socle, les différentes primitives cartographiques dont elles ont besoin et, de préférence, de concert afin de parvenir à un système de représentation qui transcende les différentes disciplines. Dans ce but, il faudra également convaincre les grands éditeurs et l’industrie du logiciel pour donner à cette vision une réalité. Cette étape semble aujourd’hui bien avancée puisqu’un nouveau groupe de travail appelé Portrayal DWG, emmené par l’U.S. Army Geospatial Center et le Defence Science & Technology Laboratories s’est structuré au sein de l’OGC.

Comment allez-vous contribuer à cette étape cruciale ?

E. B. En parallèle de nos travaux conceptuels, nous avons entamé une phase de mise à l’épreuve de notre standard, afin de montrer ce que l’on peut concrètement faire avec. Précisément, nous avons réalisé une implémentation de référence de notre standard sur Orbisgis, plateforme de recherche sur laquelle nous avons par exemple déjà développé un programme collaboratif de cartographie du bruit qui, d’une certaine manière, constitue déjà un test de ce nouveau standard avec quelques extensions concrètes de symbologie. Nous utiliserons cette réalisation pour accompagner les acteurs du nouveau groupe de travail. Cela étant, cet accompagnement ne pourra se faire sans soutien financier car il reste du chemin à faire.

L’enjeu est important ?

E. B. Ce travail affirme le CNRS comme un partenaire de recherche capable de mettre à contribution ses connaissances au bénéfice d'activités de standardisation dans le domaine de la cartographie à l'international. Nous espérons maintenir cette dynamique en activant des programmes de recherche dans ce but, en fédérant les disciplines scientifiques, des géographes aux informaticiens. Nous devons monter en puissance et trouver ainsi des financements. Car sans cartes, la donnée géographique n’a pas de sens ! ♦

- 1. Olivier Ertz est professeur au sein du Media Engineering Institute de la Haute École d'ingénierie et de gestion du canton de Vaud (HES-SO, Suisse).

- 2. Erwan Bocher travaille au Laboratoire des sciences et techniques de l'information, de la communication et de la connaissance (unité CNRS/ENI Brest/Univ. Bretagne Sud/Univ. Bretagne occidentale/Ensta Bretagne/IMT Atlantique-Institut Mines-Télécom

- 3. Bocher, E. et Ertz, O. 2018. “A redesign of OGC Symbology Encoding standard for sharing cartography”, PeerJ Computer Science, 4:e143. https://doi.org/10.7717/peerj-cs.143

Mots-clés

Partager cet article

Auteur

Né en 1974, Mathieu Grousson est journaliste scientifique. Diplômé de l’École supérieure de journalisme de Lille, il est également docteur en physique.

Commentaires

merci pour ce post.

Isabelle TREGUER le 20 Novembre 2020 à 12h04Connectez-vous, rejoignez la communauté

du journal CNRS