Alexandre Gramfort, ERC Starting Grant 2015

Les neurosciences produisent de plus en plus de données ouvertes, souvent plusieurs téraoctets par étude. Tout l’enjeu pour exploiter pleinement ce potentiel est de concevoir des outils algorithmiques capables de décrypter et d’analyser ces grandes quantités de données de façon efficace. C’est l’objectif d’Alexandre Gramfort, enseignant-chercheur à Télécom ParisTech et membre du Laboratoire traitement et communication de l’information (LTCI, CNRS/Telecom ParisTech), qui avec son ERC Starting Grant Signal processing and Learning Applied to Brain data(SLAB), souhaite apporter une meilleure interprétation des signaux électrophysiologiques des cerveaux sains et malades, pour mieux en comprendre le fonctionnement.

Comprendre comment fonctionne le cerveau est un des challenges du 21e siècle. Les masses de données produites par les études laissent espérer une meilleure compréhension de cet organe. Encore faut-il savoir leur donner du sens.

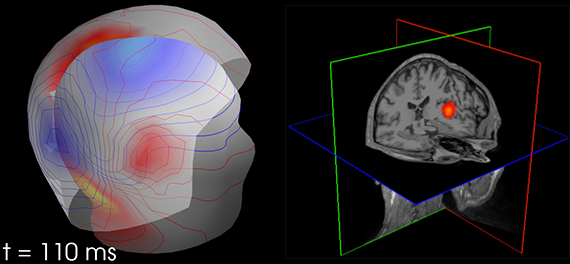

Le projet d’Alexandre Gramfort se base sur trois types de signaux enregistrés en imagerie fonctionnelle cérébrale : l’électroencéphalogramme (EGG), type d’enregistrement le plus connu, mais aussi le magnétoencéphalogramme (MEG), et l’EGG intra crânien (iEGG) qui est une mesure invasive dans le cas de malades devant être opérés. Les signaux mesurés dans les trois cas sont les conséquences de l’activité électromagnétique des neurones, soit globalement depuis l’extérieur de la tête (EGG et MEG), soit localement à l’intérieur du cerveau (iEGG). Pour son projet, Alexandre Gramfort aura accès à des mesures rares, avec parfois les trois enregistrements en simultané de patients, pour permettre une mise en correspondance et ainsi, on peut l’espérer, une description plus fine des phénomènes. Des collaborations avec le Neurospin du CEA et l’hôpital de la Timone à Marseille ont permis de recueillir des données anonymisées, respectivement sur des personnes saines ou malades.

Pour développer cette technologie capable d’extraire les informations des signaux émis par le cerveau, plusieurs problématiques se posent en traitement du signal et en apprentissage (machine learning). Tout d’abord il s’agit de localiser finement l’activité cérébrale, ce qui pose des questions de problèmes inverses, ici de grandes dimensions et sous-déterminés puisqu’il y a beaucoup d’inconnues et de paramètres à estimer, et beaucoup plus d’inconnues que de mesures. Pour représenter de façon la plus fidèle possible le modèle, il est nécessaire d’optimiser les paramètres de celui-ci de façon à « coller » aux mesures en imposant des propriétés physiologiquement plausibles aux solutions. Des outils algorithmiques spécifiques sont donc nécessaires pour ce type d’analyse. Comprendre comment fusionner les différents types de données issus des enregistrements est également un objectif, pour mieux décrire le cerveau de manière spatiale et temporelle. Le but est ainsi de réussir à créer une image en haute résolution du cerveau complet à une échelle de chaque milliseconde.

D’autres problématiques sont posées par les différences de signaux émis par les neurones. En effet, chaque population de neurones (du même type, au même endroit) émet à une certaine fréquence. De plus, une mesure n’offre qu’une vue macroscopique de plusieurs millions de neurones dans la même zone. Quand les populations de neurones communiquent, ces interactions se retrouvent dans des phénomènes de couplage entre les fréquences. Impossible alors de se contenter d’un modèle qui suppose que les fréquences sont indépendantes, il est nécessaire de trouver les bons modèles pour capturer ces phénomènes d’interactions neuronales. Pour cela, le cerveau doit être vu comme un système dont les états changent, avec une modélisation de ses signaux qui sont non-stationnaires, puisqu’ils évoluent dans le temps.

Enfin, un dernier objectif est le développement d’algorithmes capables de gérer ces masses de données pour mieux apprendre les signatures temporelles des événements cérébraux. Cela demande un apprentissage (machine learning) à partir des informations obtenues précédemment, avec une rapidité compatible à une utilisation dans un contexte médical.

Ce projet permettra donc à terme une meilleure compréhension du fonctionnement du cerveau en général, avec un apport aux sciences cognitives. Mais les applications cliniques seront également impactées, puisque la technologie développée pourra quantifier certains phénomènes chez des personnes touchées par l’épilepsie, les problèmes de tremblements (essential tremor), l’autisme ou encore les troubles du sommeil. Les résultats fournis par le logiciel pourront être utilisés comme un marqueur, qui permettra d’affiner par exemple un traitement en fonction du patient.

Voir le communiqué de presse commun avec Télécom ParisTech