Adrien Bartoli : « Augmenter les images endoscopiques pour accompagner le chirurgien »

Adrien Bartoli devient membre junior de l’Institut Universitaire de France au 1er octobre 2016. Spécialiste de la vision par ordinateur, il applique le résultat de ses recherches à la réalité augmentée en endoscopie, cette chirurgie où le geste est guidé par l’image issue d’une caméra. Ce champ d’application lui apporte de nouvelles problématiques pour alimenter sa recherche théorique.

Vos travaux portent sur la vision 3D par ordinateur, notamment dans le domaine médical.

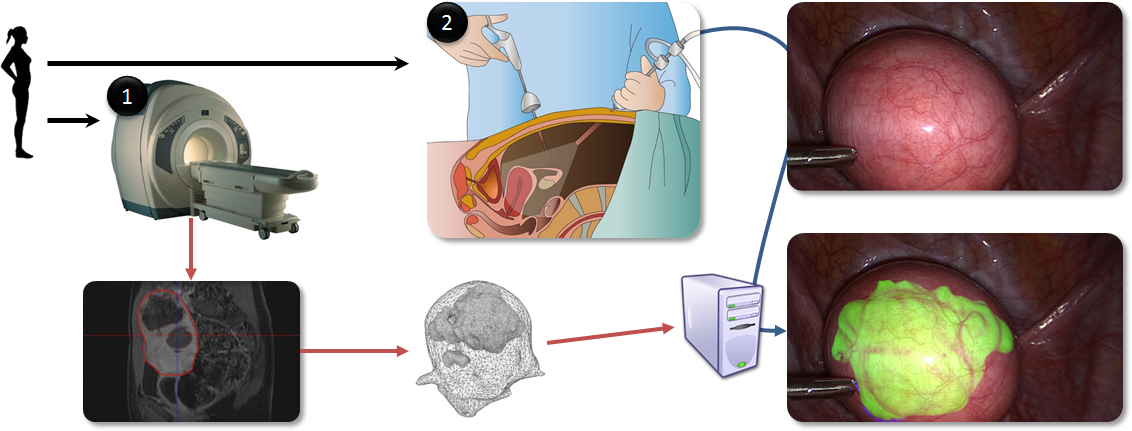

Adrien Bartoli : Effectivement, je me consacre principalement à l’aspect théorique de ce champ de recherche, et nous avons de belles applications en médecine. Je m’intéresse aux problèmes géométriques pour permettre aux ordinateurs de « voir » en 3D comme nous le faisons avec nos yeux, pour avoir des notions de profondeur et se repérer dans l’espace notamment. C’est un domaine à la frontière entre les mathématiques appliquées et l’informatique. Pour comprendre les aspects théoriques sur lesquels je travaille, il est important de comprendre les problématiques que pose l’application médicale de nos travaux. Nous mettons la vision par ordinateur au service de la chirurgie minimalement invasive, qui utilise comme interface entre le patient et le chirurgien une caméra appelée endoscope. Ce type de chirurgie a de nombreux avantages pour le patient en termes de risque d’infection et de traumatisme, mais le chirurgien est privé du sens du toucher pour manipuler les organes qu’il opère, et repérer par exemple les tumeurs qui sont des amas plus durs. Il nous a donc fallu trouver de nouvelles approches pour compenser cette perte d’information. Notre but est d’apporter de l’aide au chirurgien en lui fournissant les informations recueillies avant l’opération sur son écran d’endoscopie pendant l’opération. Pour cela, à partir des images IRM ou scanner, nous créons un modèle 3D de l’organe qui va être opéré, et des éléments particuliers dans cet organe comme les tumeurs. Quand le chirurgien commence à opérer par endoscopie, c’est-à-dire en réalisant de petites incisions pour y insérer les instruments et la caméra, nous plaçons le modèle 3D de l’organe sur l’image de l’endoscope et créons une transparence virtuelle qui permet de voir à travers l’organe pour repérer la position des tumeurs à opérer.

Quelles sont les problématiques auxquelles vous êtes confronté pour réaliser cette application ?

A. B. : Notre principal défi est de remettre le modèle 3D dans le bon repère pour qu’il corresponde au pixel près à l’organe qui s’affiche sur l’écran de l’endoscope. Ce n’est pas seulement un problème de changement d’orientation, il y a également tout un travail sur les modifications subies par le corps du patient entre l’IRM et le moment de l’opération. En effet, la maladie a pu évoluer, mais surtout il y a des mouvements : le patient respire, l’abdomen est gonflé au CO2 pour permettre l’intervention par endoscopie, et le chirurgien déplace sa caméra. Au niveau mathématique, la difficulté est de modéliser les transformations des organes de manière réaliste, puis d’estimer ces dernières à partir de données réelles. Nous cherchons à ce que la formulation soit suffisamment contrainte pour être certains d’obtenir la bonne solution. Ce problème d’unicité de la solution est important pour la robustesse du système. Il faut bien imaginer que l’on passe d’une image IRM ou scanner où l’on voit en tout point du volume et en noir et blanc, à une image de surface en couleurs avec l’endoscope. Le système doit s’adapter en direct aux gestes du chirurgien. La réalisation en temps réel requiert des opérations informatiques en parallèle, avec beaucoup de paramètres à estimer. Une des plus grosses difficultés est bien sûr d’assurer le repérage de l’organe dans l’image endoscopique issue du flux vidéo, alors qu’il peut y avoir de la fumée, des liquides, bref des conditions où il est difficile pour l’ordinateur de comprendre ce qui se passe dans l’image.

Des perspectives pour la suite du projet ?

A. B. : Nous avons déjà un prototype qui est utilisé pour les organes peu déformables comme l’utérus à l’Hôpital Estaing à Clermont-Ferrand. Notre objectif est d’étendre cette technique à des organes plus difficiles car plus « mous », comme le foie où il y a pour l’instant peu d’opérations en endoscopie car c’est un organe difficile d’accès. Ce serait donc un vrai challenge pour sécuriser le geste chirurgical. En effet, une des originalités de notre équipe, c’est que nous sommes spécialisés à la fois en réalité augmentée et en vision 3D pour les objets déformables. Peu d’équipes maîtrisent la vision 3D pour des objets déformables. Cela nous place donc dans une position privilégiée sur le thème de la réalité augmentée en endoscopie.

Endoscopie augmentée

Audiodescription

Parcours

Adrien Bartoli a soutenu sa thèse en 2003 au sein de l’équipe Perception du centre Inria Grenoble – Alpes. Il a ensuite réalisé un post-doctorat à l’Université d’Oxford en 2004. Recruté au CNRS à l’automne 2004 au sein de l’Institut Pascal, il a été professeur visiteur à l’Université de Copenhague entre 2006 et 2009. Adrien Bartoli a obtenu son HDR à l’Université Blaise Pascal en juin 2008. Devenu professeur à l’Université d’Auvergne en 2009, il a obtenu une ERC Consolidator Grant en 2013. Il dirige actuellement l’équipe ALCoV (Advanced Laparoscopy and Computer Vision) avec Michel Canis au sein du laboratoire Image Sciences for Interventional Techniques (ISIT - CNRS/Université d’Auvergne).